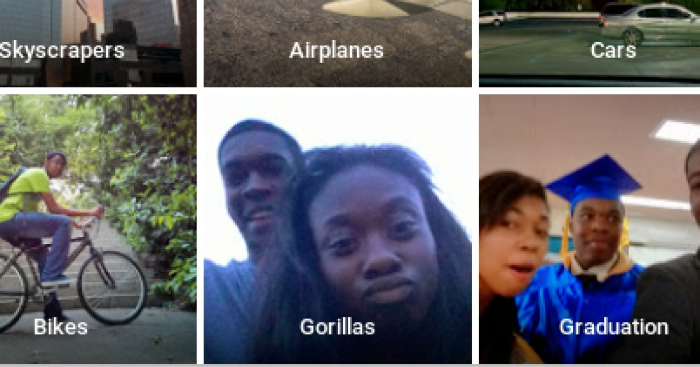

Google Photos là ứng dụng có khả năng tự động nhận diện và gắn nhãn tên người, địa điểm và đồ vật trong hình ảnh, cho phép người dùng tìm kiếm hình ảnh theo từ khóa. Tuy nhiên, Jacky Alciné, một kỹ sư phần mềm, đã phát hiện ra rằng ứng dụng này đã gắn nhãn sai các bức ảnh của anh và một người bạn, cả hai đều là người da đen, là “khỉ đột”.

Đây là một sự cố rất nhạy cảm vì nó liên quan đến vấn đề phân biệt chủng tộc. Google đã nhanh chóng xin lỗi và hứa sẽ khắc phục sự cố. Tuy nhiên, sau 8 năm, Google cũng như các công ty công nghệ khác như Apple, Amazon và Microsoft vẫn chưa có cách giải quyết triệt để vấn đề này, mà chỉ đơn giản là loại bỏ từ khóa “khỉ đột” khỏi tính năng tìm kiếm.

Không thể tìm kiếm phân loại “khỉ đột”

The New York Times đã thử nghiệm chức năng tìm kiếm hình ảnh dựa trên từ khóa của Google Photos bằng cách tạo một bộ sưu tập gồm 44 hình ảnh có người, đồ vật hàng ngày, và động vật. Kết quả cho thấy Google Photos có thể tìm ra chính xác hình ảnh khi nhập từ khóa “mèo”, “chuột túi” và hầu hết các loài động vật khác. Nhưng khi nhập từ khóa “khỉ đột”, ứng dụng không hiển thị bất kỳ hình ảnh nào trong bộ sưu tập.

Apple Photos cũng gặp phải vấn đề tương tự như Google Photos. Ứng dụng này có thể nhận diện được các loài động vật cụ thể, nhưng không thể nhận diện được các loài linh trưởng. Trong khi đó, Microsoft OneDrive không thể nhận diện được bất kỳ loài động vật nào, còn Amazon Photos thì sẽ hiển thị tất cả các loài động vật khi người dùng nhập từ khóa liên quan.

Google và Apple là hai công ty cung cấp nền tảng cho hầu hết các điện thoại thông minh trên thế giới. Tuy nhiên, hai công ty này lại không dám cho phép người dùng tìm kiếm các loài linh trưởng trên ứng dụng của họ, do sợ lặp lại lỗi như 8 năm trước.

Từ khóa này có thể không quan trọng lắm với người tiêu dùng. Nhưng điều này cho thấy rằng các dịch vụ dựa trên AI vẫn còn tồn tại các lỗ hổng không thể sửa chữa. Alciné cho biết rằng việc Google vẫn chưa giải quyết triệt để vấn đề khiến anh cảm thấy rất thất vọng, và cho rằng xã hội ngày nay quá tin vào công nghệ.

Lỗi “khỉ đột” là kết quả của việc phân biệt chủng tộc trong dữ liệu. Hai cựu nhân viên của Google cho biết họ đã không huấn luyện AI với đủ số lượng ảnh của người da đen, dẫn đến việc AI không nhận diện được người có làn da sẫm màu và nhầm lẫn họ là khỉ đột.

Lỗi tiềm ẩn trong hệ thống AI

Việc Google loại bỏ từ khóa “khỉ” hay “vượn” là một cách tiếp cận phổ biến trong ngành công nghệ AI. Các công ty thường chặn các từ khóa hoặc hình ảnh vào ra của AI để tránh gây ra các sự cố, thay vì đi sâu vào nguyên nhân gốc rễ của vấn đề.

Vicente Ordóñez, nhà nghiên cứu thị giác máy tính tại Đại học Rice nói rằng: “Việc giải quyết những vấn đề này là rất quan trọng. Làm sao chúng ta có thể tin tưởng AI trong các trường hợp khác?” Nếu AI được áp dụng vào các sản phẩm an ninh hay y tế, thì lỗi này có thể gây ra các hậu quả nghiêm trọng.

Các sản phẩm thị giác máy tính khác cũng đã bị chỉ trích dữ dội khi gây ra lỗi nghiêm trọng. Ví dụ như: webcam theo dõi khuôn mặt của HP, không thể nhận diện được một số người da sẫm màu. Apple Watch không theo dõi được nồng độ oxy trong máu của một số màu da; hay camera an ninh Nest của Google nhầm một số người da đen là động vật trong quá trình thử nghiệm.

Margaret Mitchell, cựu nhà nghiên cứu trưởng nhóm AI của Google, cho biết không có hệ thống AI nào hoàn hảo được. Với hàng tỷ người dùng hàng ngày, kể cả những sai sót hiếm gặp cũng có thể xảy ra. “Chỉ một sai lầm cũng có thể gây ra những tổn thương xã hội lớn”, Mitchell nói.

Michael Marconi, phát ngôn viên của Google, cho biết rằng công ty đã quyết định không cho phép Photos gắn nhãn bất kỳ thứ gì là “khỉ” hay “vượn” vì cho rằng việc làm này sẽ mang lại nhiều rủi ro hơn so với lợi ích.

- Minh Tuấn Mobile mở đặt hàng iPhone 16 Series chính hãng VN/A - 20/09/2024

- iPhone SE 4 sở hữu nhiều nâng cấp đáng chú ý - 11/04/2024

- Galaxy Watch FE giá rẻ sắp được Samsung cho ra mắt - 08/04/2024